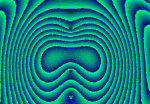

Op Art and More

Sound and Waves - Klangbilder - Klangspiele - Stochastische Musik

Sound Machine

Die Klangbilder und Töne sollen eine Reminiszenz an die Jazz-Rock Gruppen

Soft Machine und Kraftwerk und insbesondere an Iannis Xenakis darstellen

Klangbilder aus der Serie "music non stop" besitzen zudem eine Verbindung mit der Philosophie des Maha Ati